Google ha introducido unas mejoras revolucionarias en los algoritmos de su buscador que hará que las consultas puedan hacerse con un lenguaje más natural. Los cambios, que se apoyan en los modelos BERT, permitirán el uso de complementos como preposiciones para enriquecer el contexto conversacional.

Google está continuamente realizando cambios en el algoritmo de su buscador para afinar cada vez más lo que la gente espera encontrar en Internet. Estas mejoras deben ser comprendidas por los dueños de las páginas web para poder posicionarse mejor. Su última actualización se orienta más en la comprensión del lenguaje.

Google tiene la imperiosa necesidad de implementar cambios con frecuencia en su buscador ya que de los miles de millones de búsquedas que se realizan cada día, el 15% son consultas nuevas.

Cambios en el algoritmo del buscador para entender el lenguaje

Al final, la búsqueda versa sobre cómo entender el lenguaje, explican en la compañía de Mountain View. Google señala que los últimos años han mejorado sus capacidades de comprensión del idioma, pero todavía están lejos de ofrecer los mejores resultados en el caso de consultas complejas o conversaciones.

Así, la gente usa palabras clave y cadena de palabras sin formular frases de manera natural, pensando en que esa es la forma en que Google entenderá mejor la consulta. Gracias al aprendizaje automático, Google ha avanzado en la comprensión del lenguaje, lo que representa “el mayor avance en los últimos cinco años y uno de los mayores avances en la historia de la búsqueda”.

Aplicación de los modelos BERT a la búsqueda

Google ha introducido una técnica basada en una red neuronal de código abierto para la formación previa al procesamiento del lenguaje natural (PNL) llamada “Bidirectional Encoder Representations from Transformers” (BERT). Esta tecnología permite a cualquiera entrenar su propio sistema de respuesta a preguntas de última generación.

Los modelos BERT tienen en cuenta el contexto completo de una palabra observando las otras palabras que aparecen antes y después de ella, lo que ayuda a comprender la intención que hay detrás de las consultas de búsqueda.

Además de este nuevo software, Google ha desarrollado un nuevo hardware, ya que los modelos que pueden construirse con BERT son demasiado complejos para el hardware tradicional. Google está usando los últimos TPU en la nube para ofrecer los resultados de búsqueda con información más relevante del modo más rápido posible.

Utilidad del nuevo modelo de búsqueda

Los modelos BERT pueden ayudar al aplicarse a los fragmentos destacados en la búsqueda, haciendo un mejor trabajo a la hora de encontrar información útil. Cuando se trata de resultados de clasificación, BERT ayuda a entender mejor una de cada 10 búsquedas en Estados Unidos y en inglés, aunque con el tiempo se extenderá a más idiomas y países.

Las consultas más largas podrán incluir preposiciones, por ejemplo, que ayudan mucho a entender el significado. El buscador entenderá así mejor el contexto de las palabras en la consulta, pudiendo hacerse búsquedas de forma más natural.

Así, en inglés el uso de las preposiciones “for” y “to” importan mucho al significado. El buscador de Google es capaz de entender mejor el contexto con estas preposiciones.

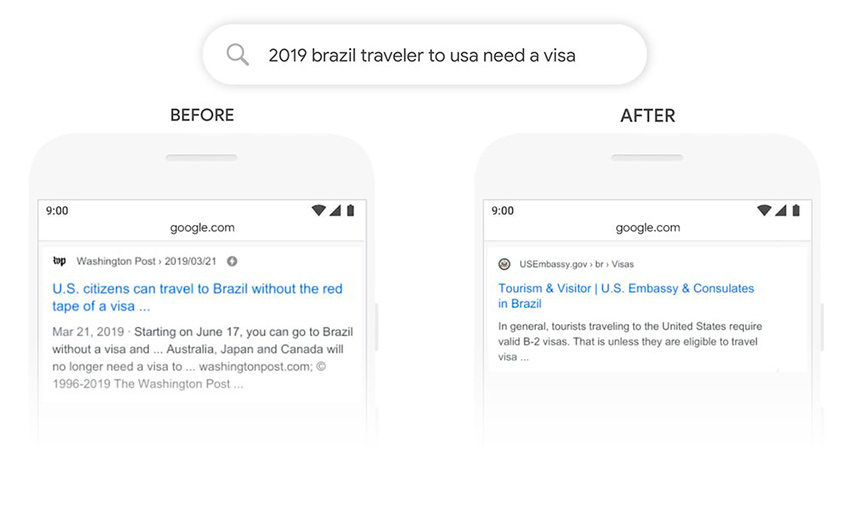

Como ejemplo realizado en el periodo de pruebas, pone la búsqueda «2019 brazil traveler to usa need a visa.» La palabra “to” en relación con las otras palabras de la consulta es importante para comprender el signficado: se trata de un brasileño que viaja a Estados Unidos, y no al revés. Antes, los algoritmos no hubieran entendido el contexto y hubiera devuelto resultados sobre ciudadanos estadounidenses que viajaban a Brasil.

Ahora con BERT se capta el matiz y pueden devolverse resultados más relevantes para esta consulta.